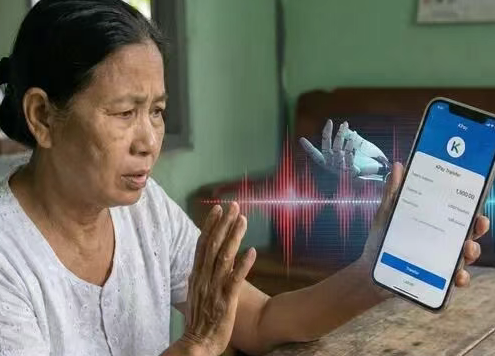

近日,一种结合生成式人工智能的新型诈骗手段在边境地区出现。诈骗团伙利用AI语音克隆与实时换脸技术,冒充受害人亲属实施诈骗。技术手段:AI语音克隆:仅需3秒清晰音频,即可完全复刻目标人声纹、语调与说话习惯;AI实时换脸:通过深度伪造技术,在视频通话中将诈骗者面部替换为受害人亲属面容。诈骗流程:

诈骗分子通过社交媒体等渠道获取受害人亲属的音频、视频片段,利用AI技术合成声音与图像,随后拨打紧急求助电话,以“被抓”“急需用钱”等话术要求转账。安全提醒:

接到涉及转账的亲友紧急来电时,应通过原有联系方式进行多重核实。建议公众在社交媒体分享内容时注意保护个人音视频信息,避免暴露声纹及面部特征。目前,相关技术已被边境电信诈骗团伙用于实际作案,警方提醒公众提高警惕,防范新型技术诈骗风险。